ELYZA は、日本語における論理的思考能力を強化した大規模言語モデル (LLM) である「ELYZA-Thinking-1.0-Qwen-32B」を開発し、商用利用可能な形で一般公開しました。同モデルは OpenAI 社の「o1/o3」シリーズや、DeepSeek 社の「DeepSeek-R1」と同様に、思考の連鎖 (Chain of Thought; CoT) を通して複雑な論理的思考を行う能力を強化した Reasoning Model です。

本記事では、モデルの概要や広範なベンチマーク結果に加え、Reasoning Model を開発する際に用いた技術的な詳細についても解説します。具体的には、思考過程を伴う学習データの収集において、モンテカルロ木探索 (MCTS) に着想を得たアルゴリズムよる最適な推論パスの探索を行い、収集された合成データによる模倣学習を実施しました。

また、今回 Reasoning Model の開発過程で得られた非 Reasoning Modelである「Shortcut Model」も併せて公開していますので、そちらの特徴もご紹介します。

軽量かつオープンな Reasoning Model: 「ELYZA-Thinking-1.0-Qwen-32B」

「ELYZA-Thinking-1.0-Qwen-32B」は、アリババ社が公開している「Qwen2.5-32B-Instruct」に対して、日本語追加事前学習と長い思考過程を伴うデータによる Supervised Fine Tuning (SFT) を実行することで、日本語における論理的思考能力を向上させたモデルです。後段の SFT では、約 150,000 件の高品質な合成データセットを使用して学習されました。

同モデルは、320 億パラメータと比較的軽量なモデルでありながら、同じ Reasoning Model である OpenAI 社の「o1-mini」に匹敵する性能を達成しました。特に、数学系のベンチマークにおいて高い性能を示しており、日英両方で「o1-mini」を上回るスコアを達成しています。各ベンチマークの内容と評価方法については、後段にて詳細に説明します。モデルは Apache 2.0 ライセンスで公開され、研究・営利目的での利用が可能です。

GPT-4oに匹敵する非 Reasoning Model: 「ELYZA-Shortcut-1.0-Qwen-32B/7B」

今回は、Reasoning Model の開発過程で生成されたデータを使用して、「Reasoning Model が深く思考して辿り着いた回答を、反射的に答えられるように暗記したモデル」の学習を行いました。具体的には、Reasoning Model の学習用に探索された多数の (問題、思考過程、回答) セットから思考過程を取り除いた (問題、解答) ペアを使用して SFT を行うことで開発されました。

すなわち、Reasoning Model の思考過程をショートカットして回答を返すように訓練されたモデルという意図を込めて、Shortcut Model と呼ぶことにしました。Shortcut Model については、320 億パラメータのモデルと 70 億パラメータのモデルの 2 種類を開発し、公開しました。こちらについても、モデルは Apache 2.0 ライセンスで公開され、研究・営利目的での利用が可能です。

以下には 320 億パラメータの Shortcut Model の性能を載せています。同モデルは、320億パラメータと軽量ながら、同じ非 Reasoning Model で商用の API が展開されている OpenAI 社の「GPT-4o」に匹敵する性能を達成しました。また、登場時にはその性能の高さから多大なインパクトを与え、長らく LLM の性能の目標とされてきた「GPT-4」に対しては、JHumanEval 以外の全てのベンチマークで上回る結果となっています。

Reasoning Model の学習

Reasoning Model は、回答を生成する前に内部思考を明に出力するよう学習された LLM です。関連する概念である「Chain of Thought (CoT)」は、LLM に中間の推論ステップを生成させることで性能向上を促す手法を指し、主にプロンプトテクニックの文脈で使われます。Reasoning Model はその CoT 機構をモデルレベルで組み込み、学習により最適化したモデルと言えるでしょう。具体的な挙動としては、Reasoning Model はユーザークエリが与えられると、まず特定のトークン (「DeepSeek-R1」の場合は ) で囲まれた思考過程を生成し、その後に回答を生成します。

通常の LLM を Reasoning Model として学習する方法としては、長い思考過程付きの教師データを使用して模倣学習 (SFT) を行う方法や、強化学習 (RL) を用いて LLM に思考過程の生成を促す方法などがあります。DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning (DeepSeek-AI, 2025) では、モデルの出力が で囲まれた思考過程を含むかどうかも報酬に組み込むことで、強化学習のみで推論動作をLLMに組み込むことに成功したと報告されています。

今回 ELYZA では、模倣学習による Reasoning Model の構築に取り組みました。長く複雑な思考を経て正解に辿り着く Reasoning Model の振る舞いを LLM に学習させるには、そのような思考過程を伴う学習データが必要です。O1 Replication Journey: A Strategic Progress Report — Part 1 (Qin+, 2024) では、327 件もの複雑な思考過程を含むデータを人手でアノテーションし学習することで、モデルに推論動作を組み込むことができたと報告されています。

しかし、長く複雑な思考過程を伴うデータのアノテーションには多大なコストがかかるため、データ量をスケールさせることが難しくなります。そのため今回は、LLM によって生成された「合成データ」を活用する方法を採用しました。

思考過程を伴う合成データセットを作成するにあたり、主に下記の課題に取り組みました。それぞれの詳細について、以降の章で解説します。

- 推論動作のアクティベート: 「思考過程を生成してから回答する」という振る舞いを、LLM にどのように促すか?

- 評価方法: 合成データを生成する際に、出力の品質 (特に回答の論理的整合性) をどのように担保するか?

- 探索戦略: 正確性の高いデータを生成するために、どのような戦略で推論パスの探索を行うか?

複雑な思考過程を伴う合成データの生成

Few-shot learning による LLM の推論動作のアクティベート

Reasoning Model の学習を行うために、特殊トークンで囲まれた思考過程 (「DeepSeek-R1」の場合は、で囲まれた部分に該当) の後に回答が続く、という形式のデータセットを作成する必要がありました。しかし、そのような形式で生成するように単にプロンプトで LLM に促したとしても、指示に従わず回答をそのまま生成してしまうことが多々ありました。

そこで今回は、LLM に「思考過程を生成してから回答する」動作を促す手段として、few-shot learning を採用しました。熟考、内省、アプローチの転換などの動作を含むような思考過程の例を人手で 10 件作成し、そこからランダムに選択した 1~3 件を few-shot example としてモデルに渡すことで、LLM は思考過程を伴う出力を生成するようになりました。以下は、実際に作成した例の 1 つです。

人手で作成したデータの例

問題

私は今北東を向いています。右に90度回転すると、どの方角を向きますか?東西南北八方位で答えてください。

思考過程

まず、問題の内容を整理しましょう。現在、ユーザーは北東を向いています。問題では、右に90度回転した際の方角を求めるように指示されています。方角は、東西南北を基準にした八方位で表されます。八方位とは、北、北東、東、南東、南、南西、西、北西の8つの方角を指します。

右に90度回転する、という状況を視覚的にイメージし、どの方角を向くことになるかを考えていきましょう。

「北東から右に90度回転する」状況を視覚的に捉えるために、方角と角度の関係について確認しましょう。北を0度として考え、各方角を一定の角度差で配置します。角度差は、360度を8等分した角度になるので、360 ÷ 8 = 45度です。

北を0度として、各方角を45度ずつ増やしていくと、以下のようになります。

- 北: 0度

- 北東: 45度

- 東: 90度

- 南東: 135度

- 南: 180度

- 南西: 225度

- 西: 270度

- 北西: 315度

- 北: 360度 (0度)

最後に360度、つまり一周した後は、再び北に戻ることになるので、この対応関係は正しいように思えます。この情報を元に、北東から右に90度回転した際の方角を特定していきましょう。

北東から右に90度回転すると、どの方角を向くかを特定します。ところで、右に回転するということは、時計回りの方向に回転することを意味します。つまり、北を向いている状態で時計回りに回転すると、北東、東、南東、南、...と進んでいくということで理解しました。現在、私は北東を向いているので、時計回りに回転すると、東、南東、南、南西、...と進んでいきます。

では、90度回転するとどの方角を向くことになるでしょうか?上記の対応関係を見ると、北東は45度地点です。この状態から時計回りに90度進むと、45 + 90 = 135度になります。

135度に対応する方角を探しましょう。南東が135度になりますね。だとすると、北東から右に90度回転すると、南東を向くことになります。

ここで一度立ち止まって、正しいかどうか確認しましょう。問題では、私が北東を向いている状態から右に90度回転した際の方角を求めるように指示されています。先ほどは、方角と角度の対応関係から計算しましたが、別のアプローチでも導出しておきましょう。

八方位をステップバイステップに回転しながら確認することで、方角を特定してみましょう。八方位を北から時計周りに見ると、北、北東、東、南東、南、南西、西、北西で、45度ずつの角度差があります。私は今北東を向いています。右に45度回転すると東を向きます。さらに45度回転すると、南東を向きます。このとき、45 + 45 = 90度回転しているので、北東から右に90度回転しています。方位は南東です。先ほどの結果と一致しました。

他に、見逃している点はあるでしょうか?例えば、「右」の考え方が違う人がいるでしょうか?いえ、一般的には右は時計回りの方向を意味するでしょう。ここに曖昧さはありません。以上の理由から、北東から右に90度回転すると南東を向くことが正しい結論と言えます。

回答

### 思考プロセス

1. **方角と角度の対応関係を考える**

- 八方位 (北、北東、東、南東、南、南西、西、北西) は、360度を8等分するので、「45度」ずつの角度差があります。

- 北を0度として、八方位を角度と対応させると、「北 = 0度、北東 = 45度、東 = 90度、南東 = 135度、南 = 180度、南西 = 225度、西 = 270度、北西 = 315度、北 = 360度 (= 0度)」となります。

2. **問題の状況を理解する**

- 現在、あなたは「北東」を向いているため、角度としては45度に位置します。

- 右 (時計回り) に90度回転するとは、現在の角度に対して + 90度することを意味します。

3. **方角の特定**

- 北東 (45度) に90度を加えると、45 + 90 = 135度になります。

- 135度に対応するのは、八方位で言うところの「南東」です。

### 結論

**「北東」から右 (時計回り) に90度回転すると、「南東」を向くことになります。**

Reference 付きデータを使用した合成データの品質自動評価

LLM が生成した回答には誤りを含むものも多く存在するため、適切に評価を行う必要があります。しかし、入力に対する出力の正しさを評価することは、正しい出力を生成することと同様に難しいタスクです。そこで今回は、使用するデータを「入力に対する正しい回答例が付与されたデータ」に絞ることで、評価タスクの難易度を下げ、LLM による自動評価を行うことにしました。具体的には、正解例を Reference として LLM-as-a-judge を行うことで、出力の妥当性を判定しました。

なお、数学や択一式の問題においては、ルールベースによる評価を行うことも一定可能です。しかし、ルールベースによる評価では全てのケースを網羅することはできないため、出力のフォーマットミスや数式の表記違いを間違いと誤判定してしまう可能性があります。今回は Ground Truth がアノテーションされたデータしか学習に使えない都合上、それらのミスも逃さず活用したかったため、より柔軟な判定が可能な LLM による評価を採用しました。これにより、自由記述式で正解が一意に決まらないタスクも、正解例を Reference として活用することで評価を行うことができました。

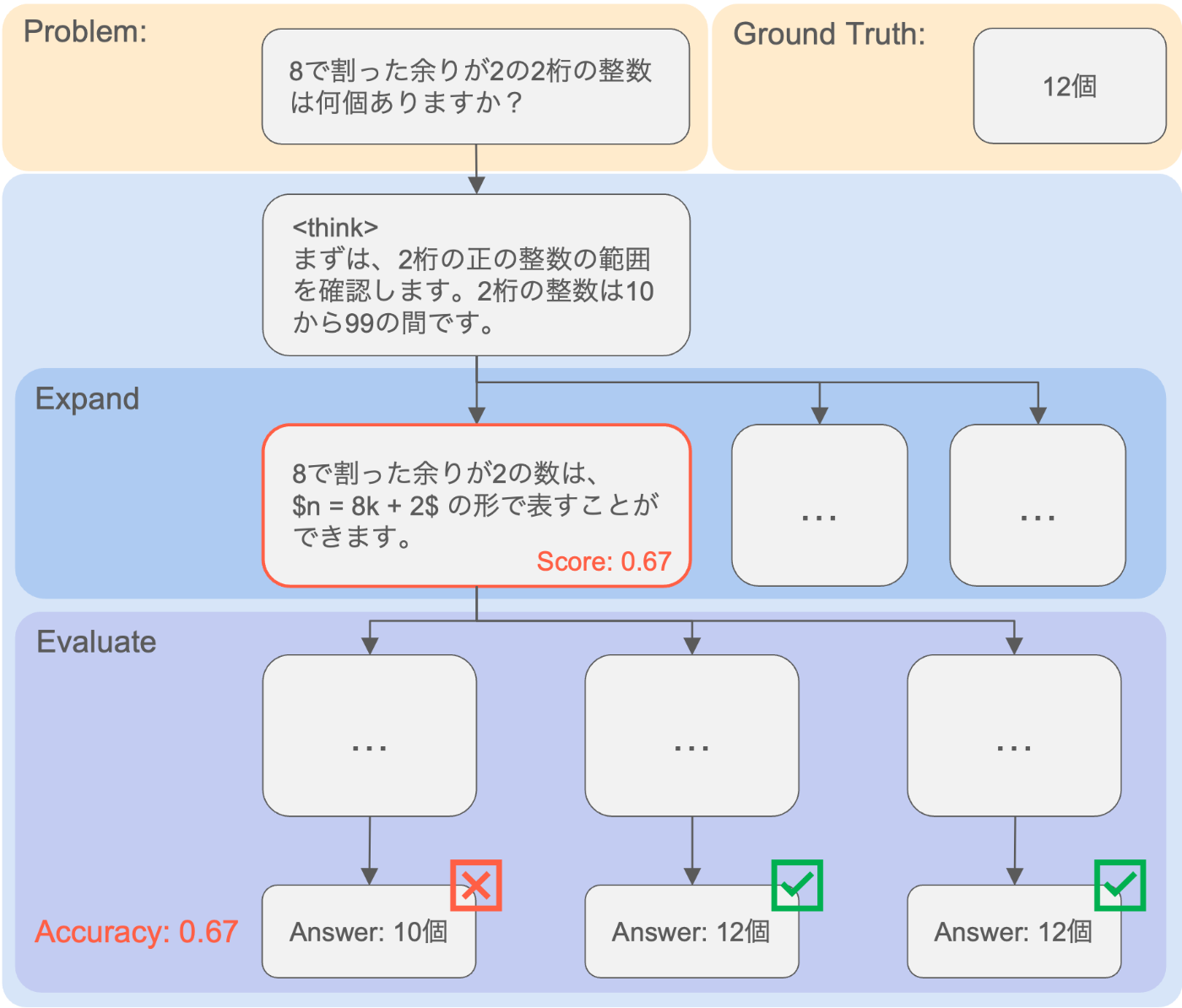

モンテカルロ木探索 (MCTS) ベースのアルゴリズムによる推論パスの探索

LLM が生成したデータに対して、アノテーションされた正解例を Reference とした LLM-as-a-judge による評価を行うことで、最終結果の論理的整合性を判定することは可能です。しかし、たまたま最終結果が合っているだけで、思考過程では論理的に誤った推論をしている可能性があります。また、Best of N によるサンプリングでは複数回答を生成し正しい回答のみを使用することになりますが、そもそもスタートの段階から全ての試行が誤った推論パスに入り込んでしまい、深く思考を続けても 1 度も正解に辿り着けないケースもあります。

そこで今回は、モンテカルロ木探索 (MCTS) に着想を得たアルゴリズムを採用しました。このアルゴリズムは、推論の途中でその時点における推論ステップの良し悪しを推定し、有望な推論ステップにリソースを集中することで、無数に存在する LLM の推論パスを効率的に探索するアルゴリズムです。LLM の推論ステップにおける正確性を評価するために MCTS を活用したアルゴリズムは多数提案されていますが、今回はそれを日本語かつ Reasoning Model の開発に応用した初の事例となります。

MCTS ベースの探索アルゴリズム

探索を行うためには、推論ステップをノードとして定義する必要があります。ノードの粒度としては、トークンレベルからソリューションレベルまで様々定義することができますが、今回は二重改行 (\n\n) を区切り文字として、各段落を1つのノード (推論ステップ) として定義しました。各ノードは、Expand と Evaluate の機能を持ちます。

-

Expand: あるノード (ある段階までの試行) から、次のノード (推論ステップ) を複数生成する操作に相当します。今回の問題設定では、LLM が

\n\nを出力するまで生成を行うことに該当します。子ノードを何ノード生成するかは、探索の幅を決定するパラメータであり、探索の精度に影響します。探索の幅を広げることで、より多様な推論パスを探索することができますが、計算コストも増加します。 - Evaluate: 生成したノードがどのくらい有望かを評価する操作です。具体的には Rollout と呼ばれる、そのノードまでの思考過程を開始地点として、最終回答までを生成する手順を複数回実行します。こうして得られた回答を LLM-as-a-judge で評価し、平均スコアを当該ノードの評価値とします。この評価値を用いて、より良い推論パスに探索が集中するようにガイドします。

Expand と Evaluate の操作を繰り返し、全てのパスが最終回答に辿り着くか指定の探索回数に達するまで探索を続けます。探索が終了したら、最終ノードにおける評価値が最も高いノードを選択し、そのノードに至るまでの思考過程とその後の回答を学習データとして収集します。

本アルゴリズムを使用することで、高品質な推論パスを探索することができますが、Expand、Rollout、評価の各操作において LLM による生成を行うため、探索時間の長さが課題となります。そこで、実際の探索過程を観察していると、初期の段階で高いスコアを持つ (Rollout がほぼ正解している) ノードに達した場合、そこから先の探索にはあまり意味がないことがわかりました。この観察結果を受け、探索途中での early stopping を導入し、あるノードの評価値が一定以上になった場合は、探索を打ち切るようにしました。これにより、探索時間を大幅に削減することができました。

今回の検証の過程で、Best of N や MCTS といった手法を用いて推論にコストをかけることで、達成可能な性能上限が引き上げられることが確認できました。下図は、(問題、正解例) ペアが与えられた数学データセットの一部を用いて探索を行った際の、推論時間に対する最高精度を示した図です (Best of N の場合は、N個の出力結果に1個正解が含まれれば良いとする)。モデルは、全て Qwen/Qwen2.5-72B-Instruct を使用しています。

合成データによる模倣学習

今まで ELYZA が作成・収集した指示学習用データを (問題、正解例) のペアとみなし、上記の手順により推論パスの探索を実行しました。結果として、一つの (問題、正解例) ペアに対して複数の異なる推論パスを付与したデータも含め、約 150,000 件の合成データが生成されました。生成された (問題、思考過程、回答) の組を DeepSeek のフォーマット (思考過程を で囲む) に整形し、日本語で追加事前学習された Qwen2.5-32B-Instruct に対して、約2エポックの Fine-tuning を行いました。

最終的には、英語における思考能力を向上させることを目的として、同じく「Qwen2.5-32B」をベースとした Reasoning Model である「DeepSeek-R1-Distill-Qwen-32B」をモデルマージしました。設定としては、ELYZA モデルを 0.7、Distill-Qwen を 0.3 の割合で重みの加重平均を取りました。結果として、英語の数学ベンチマークである MATH-500 のスコアが向上しました。

Shortcut Model の学習

Reasoning Model は、回答を生成する前に深く思考することで、未知のタスクや複雑な論理的思考が要求されるタスクにおいて、高い性能を達成することができます。しかし、Reasoning Model は思考過程の分多くの出力トークンを消費するため、推論コストやレイテンシの観点からは望ましくない場合もあります。例えば、深く考えずとも反射的に回答できるタスクなど、従来の非 Reasoning Model のように即時で回答を出力して欲しいケースもあります。

そこで、Reasoning Model が深く思考して辿り着いた回答を、反射的に答えられるように暗記したモデル (= Shortcut Model) の開発に取り組みました。今回、MCTS ベースのアルゴリズムによる推論パス探索により、高品質な (問題、思考過程、回答) の組が大量に生成されました。ここから「思考過程」部分を除いた (問題、回答) ペアを使用して通常の Instruction Tuning を行うことで、Shortcut Model を開発しました。

今回使用したベンチマークについて

今回は、開発したモデルの性能を多角的に評価するために、「数学の能力を測るベンチマーク」「コーディング能力を測るベンチマーク」「日本語における知識や指示追従能力を測るベンチマーク」に大別される 6 つのベンチマークを使用しました。

数学能力を測るためのベンチマーク

MATH-500

MATH-500 は、Let’s Verify Step by Step (OpenAI, 2023) の論文にて使用された、MATH データセットの 500問のサブセットで構成される数学ベンチマークです。評価方法およびプロンプトは、OpenAI 社が提供している simple-evals を参考に実装しました。評価結果のスコアとしては、以下の式で表される

なお、

simple-evalsの実装では数式の正誤判定を行う際、数式の表記の違いや等価な式変形を許容するために、LLM による判定を行なっています。今回の評価もそれに倣い、gpt-4o-mini-2024-07-18 による正誤判定を行いました。なお、正誤判定を行う際のプロンプトについても、simple-evals の実装をそのまま使用しています。

MATH-500 (邦訳版)

今回は、日本語における数学能力を測るために、MATH-500 の日本語訳版を作成しました。翻訳は LLM を用いて行い、入力文の機械翻訳を行いました。出力文は、基本的に \frac{3}{56} や x^5 - x^4 + x^3 - x^2 + x - 1 のように数式で構成されているため、翻訳を行なっていません。例外として、一部 \text{Evelyn} のように問題文中の選択肢が答えになっているケースに対処するため、文中の人名などの固有名詞については、英語表記のまま残すようにプロンプトを調整しました。なお、推論・評価については、MATH-500 と同様のコードベースで行なっています。

コーディング能力を測るためのベンチマーク

JHumanEval

JHumanEval は、英語の HumanEval ベンチマークを日本語訳して作られた、LLM のコーディング能力を測るための日本語ベンチマークです。推論は simple-evals のプロンプトを日本語訳したものを使用し、評価は JHumanEval の README に倣い、Hugging Face Evaluate を使用して

以下の関数の定義部と docstring を読み、その関数で説明されている内容を完全に実装してください。あなたの回答には、この関数のコードだけを含めてください。

{question}

評価方法やプロンプトは、本家に合わせて実装しています。

日本語における知識や指示追従能力を測るためのベンチマーク

JMMLU

JMMLU は、広範囲な分野にわたる LLM の知識を測定するためのベンチマークである MMLU を日本語訳して作られた問題と、日本特有の文化的文脈に基づいた問題 (日本語問題) からなるベンチマークです。推論および評価は simple-evals のコードを参考にし、zero-shot での評価を行いました。スコアは、

Japanese MT-Bench

Japanese MT-Bench は、英語の MT-Bench を日本語訳して作られた日本語ベンチマークです。本ベンチマークは、LLM の日本語対話性能を測るためのベンチマークで、8 つのカテゴリに分かれた 80件の対話から応答の適切さを評価します。カテゴリには Math と Coding も含まれますが、量的には各カテゴリ 10 件と少ないため、今回は日本語の対話性能を測るためのベンチマークと大別しました。

評価の際は Japanese MT-Bench のリポジトリのコードベースを参考にし、gpt-4-0613 を使用した自動評価を行っています。スコアは 1~10 の 10 段階で評価され、最終的なスコアは全カテゴリの平均値を取ることで算出しています。

ELYZA Tasks 100

ELYZA Tasks 100 は、LLM の指示に従う能力や、ユーザーの役に立つ回答を返す能力を測ることを目的として ELYZA が開発した日本語ベンチマークです。評価は 1~5 の 5 段階で、gpt-4o-2024-05-13 を使用した自動評価を行なっています。

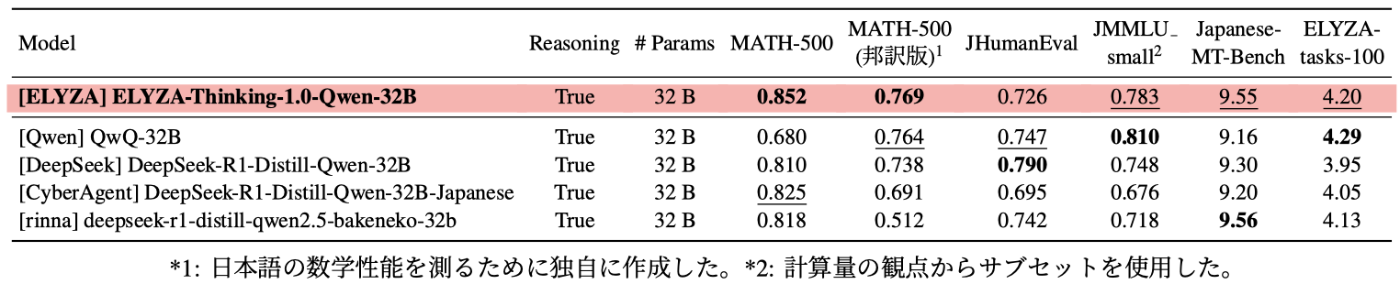

Reasoning Model の評価: 同規模のパラメータ数を持つオープンモデルとの比較

今回開発した Reasoning Model である「ELYZA-Thinking-1.0-Qwen-32B」について、同規模のパラメータ数を持つオープンな Reasoning Model との比較を行いました。同モデルは、複数のベンチマークに渡ってトップレベルの性能を達成しており、JHumanEval 以外の全てのベンチマークにおいて、最も高いか 2 番目に高いスコアを達成しています。特に、数学のベンチマークにおいて高い性能を発揮し、DeepSeek 社が公開している「DeepSeek-R1」の蒸留モデルである「DeepSeek-R1-Distill-Qwen-32B」や、Qwen チームが開発した「QwQ-32B」と比較しても、日英両方で高いスコアを達成しました。

今回は主に日本語で構成されたデータセットによる学習を行っているため、JMMLU、Japanese MT-Bench、ELYZA Tasks 100 といった一般的な日本語能力を測定するベンチマークのスコアも、元の「Qwen2.5-32B-Instruct」から引き上げられています。また、同規模のパラメータ数を持つ他の日本語モデルと比較しても、一貫して同等かそれ以上のスコアを達成しています。

一方で、コーディングタスクである JHumanEval においては、ベースモデルである「Qwen2.5-32B-Instruct」よりもスコアが下がってしまっています。これは、今回学習に使用した問題セットにコーディングタスクが十分に含まれていなかったことが原因と考えられます。今後は、コーディングタスクを含むデータセットの拡充を行うことで、コーディングタスクにおける性能向上を図る予定です。

Shortcut Model の評価

320億パラメータモデル

Reasoning Model 開発の過程で得られた Shortcut Model である「ELYZA-Shortcut-1.0-Qwen-32B」についても、同様に評価を行いました。Shortcut Model は、数学やコーディングと比べて深く考えても回答が改善されにくい一般的な日本語タスク (JMMLU、Japanese MT-Bench、ELYZA Tasks 100) における性能が高く、Reasoning Model の「ELYZA-Thinking-1.0-Qwen-32B」やベースモデルの「Qwen2.5-32B-Instruct」よりも高いスコアを獲得しています。

興味深い点として、Reasoning Model と Shortcut Model とで得意とするタスクの性質が異なることが挙げられます。今回「ELYZA-Thinking-1.0-Qwen-32B」と「ELYZA-Shortcut-1.0-Qwen-32B」の学習には同じ問題セットを使用しており、差分としては (問題、思考過程、回答) の組のうち「思考過程」を学習時に使用しているかどうか、という点のみです。それにも関わらず、Reasoning Model は数学のような深く考えることで回答が改善されるタスクにおいてスコアを伸ばしている一方、Shortcut Model は一般的な日本語タスクにおいてスコアを伸ばしており、性質の違いが見られます。

このことから、長い思考過程付きのデータを使用して学習することで、同じ問題セットを使用してもより効率的にモデルの論理的思考能力を伸ばすことが可能であることが示唆されます。一方で、深い思考が不要なタスクにおいては、学習効率が変わらないか、むしろ悪化してしまう可能性があると考えられます。これらを踏まえ、如何にして 1 つのモデルで両方の性能を伸ばすか、という点は今後の課題となります。

70億パラメータモデル

70億パラメータモデルの Shortcut Model についても評価を行った結果、320億パラメータのモデルと同様に、JMMLU、Japanese MT-Bench、ELYZA Tasks 100 といった日本語能力に関するベンチマークのスコアが向上していることがわかりました。一方で、数学のように深く考える必要があるタスクについては、ややスコアを落とす結果となっています。

Shortcut Model に関する考察

Shortcut Model の学習には、Reasoning Model を開発する過程で探索された正確性の高い推論パスから導かれた回答のみを使用しています。結果として、今回開発した Shortcut Model は、深い思考がそこまで必要でない日本語タスクにおける性能が高いモデルとなりました。

今回は、思考過程を省いた Shortcut Model という形で検証しましたが、Reasoning Model や Agent などに関しても、大量の計算リソースを費やして生成された高品質な合成データを使用することで高性能化を図ることは可能です。このように、実質的に推論時の探索コストを開発時に転嫁し、高性能かつ高コスパなモデルを開発するトレンドは今後も続くと考えられます。

評価結果 (一覧)

前述の通り、今回使用したデータセットにはコーディングタスクが十分に含まれていなかったため、コーディングタスク (JHumanEval) における性能向上があまり見られませんでした。しかし、コーディングタスクはテストケースを用いた verification により正誤判定を自動で行うことができるため、今回採用した MCTS ベースのアルゴリズムを使用して合成データを生成することが可能です。したがって、コーディングに関する問題とテストケースのペアデータを拡充することで、コーディングの能力についても性能向上を図ることができると考えています。

また、今回 Reasoning Model として学習したモデルの一般的な日本語タスク (ELYZA Tasks 100、Japanese MT-Bench、JMMLU) における性能の伸びが、Shortcut Model と比較して限定的であることがわかりました。数学やコーディングといった複雑な思考を必要とするタスクの性能と、一般的な知識や創作能力が要求されるタスクでの性能を両立したモデルの開発が今後の課題となります。

本記事では、ELYZA が開発し公開した Reasoning Model 「ELYZA-Thinking-1.0-Qwen-32B」と、Shortcut Model「ELYZA-Shortcut-1.0-Qwen-32B/7B」の技術的な詳細と評価結果について解説しました。ELYZA では引き続き、最先端の研究開発に取り組んでいくとともに、その研究成果を可能な限り公開・提供することを通じて、国内における LLM の社会実装の推進、並びに自然言語処理技術の発展を支援してまいります。

ここまでお読みいただき、ありがとうございました。ELYZA はリサーチャーはもちろん、ソフトウェアエンジニアや AI コンサルタントなど、様々な職種で一緒に事業を前に進めてくれる仲間を募集しています。詳しくは下記をご覧ください。

Views: 1