はじめに

日本時間2025年4月15日早朝にOpenAIからGPT-4.1が発表されました。

- APIのみで利用可能

- 3種類のラインナップがあり、GPT4.1、GPT-4.1 mini、GPT-4.1 nano

- コーディングに最適で、指示のフォローが強化されており、100万トークンの長いコンテキストに対応

- 開発エージェント(CursorやCline、Roo Code)の利用を意識したモデル

- 汎用エージェント(ManusやGenSparkのスーパーエージェント)の利用も意識したモデル

詳細な一次情報は、下記YouTubeと、OpenAI公式のドキュメントにあります。

APIはOpenAIのPlaygroundで試せます。ぜひGPT-4.1を試してみましょう!

OpenAI CEOのサム・アルトマン氏のコメント。

概要

開発者向けに特化した「GPT-4.1」ファミリーとして3つの新モデルを発表しました。

- GPT-4.1:最も高性能なモデル

- GPT-4.1 Mini:中間レベルのモデル

- GPT-4.1 Nano:最小・最速・最安値のモデル

全てのモデルが100万トークンのコンテキスト長をサポートし、GPT-4oより優れ、多くの点でGPT-4.5に匹敵または上回る性能を持っています。

特徴

回答精度とレイテンシー(回答の待ち時間)のバランスが大幅に改善しているとのことです。特に、GPT-4.1 nanoでは高速でありながら、高い回答精度を維持しています。

YouTube動画で、各モデルの推奨用途について説明がありました。

- GPT-4.1:コーディング、指示の遵守、長文コンテキスト処理などの主要タスク向け

- GPT-4.1 Mini:より単純なユースケースで高速処理が必要な場合

- GPT-4.1 Nano:オートコンプリート、分類、長文書からの情報抽出などの基本タスク向け

コーディング性能

SWEBench

GPT-4.1は55%の精度を達成(GPT-4.0の33%から大幅向上)して、GPT-o1、o3 miniモデルよりも優れた性能を出しています。

Aider’s polyglot benchmark

複数のプログラミング言語に対応して、差分(diff)形式での出力が大幅に改善(GPT-4oから2倍に向上)、Mini版もGPT-4o Miniより大幅に改善しています。

ロングコンテキスト

GPT-4.1では全モデル(Nanoを含む)で最大100万トークンのコンテキスト長をサポートします。以前のモデル(128Kトークン)から8倍の拡張されたことになります。

Haystack accuracy

Haystack accuracyという指標では、ドキュメントの位置(先頭、中間、末尾)に関わらず安定した検索性能となったそうです。これは、miniでもnanoでも同じだったそうです。下記図を見ると、全体的に情報を見つけられているようですね。

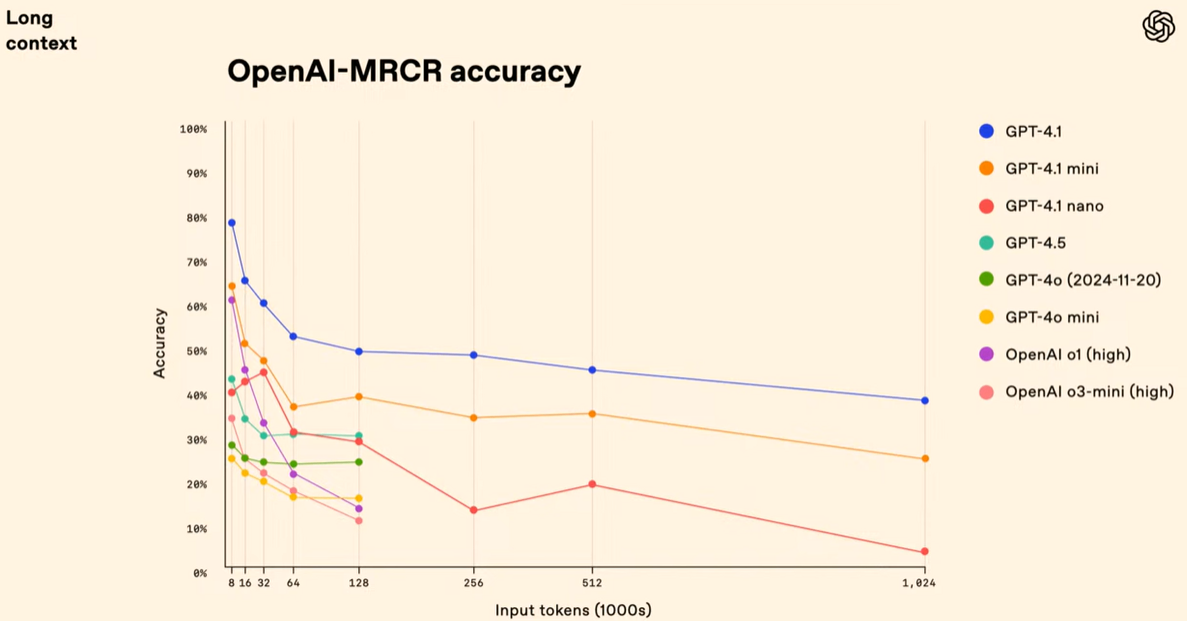

OpenAI MRCR

この指標は、より複雑な長文コンテキスト処理能力を評価できるそうで、GPT-4.1はGPT-4oを大幅に上回り、100万トークンまで安定した性能を維持しているそうです。

この評価方法はHugging Faceで公開されています。長文処理研究の進展を促進することが目的。

このサイトによると、OpenAI MRCRは、人工知能(AI)が「長い文章の中から、似ているけれど違う複数の情報(=針)」をきちんと見つけ分けられるかどうかを評価するためのデータセットだそうです。もともとGoogleの「Gemini」の研究 (https://arxiv.org/pdf/2409.12640v2) から着想を得ているそうです。OpenAI版では、このタスクの難しさをさらに高めたり、誰でも同じ実験を再現できるようにデータを公開しているとのこと。

マルチモーダル

動画

Video MMEベンチマークで72%のスコアを達成(最先端の性能)し、字幕なしの30〜60分の動画を理解し、多肢選択問題に回答する能力があります。

画像

全モデルでマルチモーダル処理能力が向上していて、特にGPT-4.1 Miniが画像理解・処理において特に高い性能を発揮しています。

料金

GPT-4.1はGPT-4oより26%安価(GPT-4oはInput$2.5, Output$10)で、GPT-4.1 Nanoは最も安価なモデルで、GPT-4o miniよりも安価(GPT-4o miniはInput$0.15, Output $0.6)です。いずれも1Mトークンあたり。

また、長文コンテキスト使用時の追加料金が発生しないのも特徴

ちなみに、他のLLMのAPIの料金は下記。いずれも1Mトークンあたり。

- Claude 3.7 SonnetはInput $3, Output $15

- Gemini 2.0 FlashはInput $0.1, Output $0.4

- Gemini 2.5 Pro PreviewはInput $1.25, Output $10.00(200Kトークン以上はInput $2.5, Output $15)

ファインチューニング

現時点で、GPT-4.1とPT-4.1 miniではファインチューニングが可能です。GPT-4.1 nanoは近日提供予定とのこと。

GPT-4.5について

APIでGPT-4.5は廃止されるそうです。GPU資源の再配分のため、今後3ヶ月以内に廃止予定とのことです。

Roo Codeで早速使える

Roo Codeでは、GPT-4.1が早速使えるようになっています!

個人的に実装している教育系アプリでローディング中にタグが表示される事象が発生したので、試しに直してもらいました。

直している様子は下記です。

複雑ではないタスクですが、なんなく修正してくれました!

おわりに

いかがでしたか。GPT-4.1は開発エージェントや汎用エージェントを意識したモデルとなっています。料金面で対抗であるClaude 3.7 Sonnetより安価であり、今後も比較しながら使ってみようと思います!また、ManusやGenSparkのスーパーエージェントで使えるようになるとどうなるか楽しみです!新しい発見がありましたら、改めて情報共有できればと思います!

Views: 0