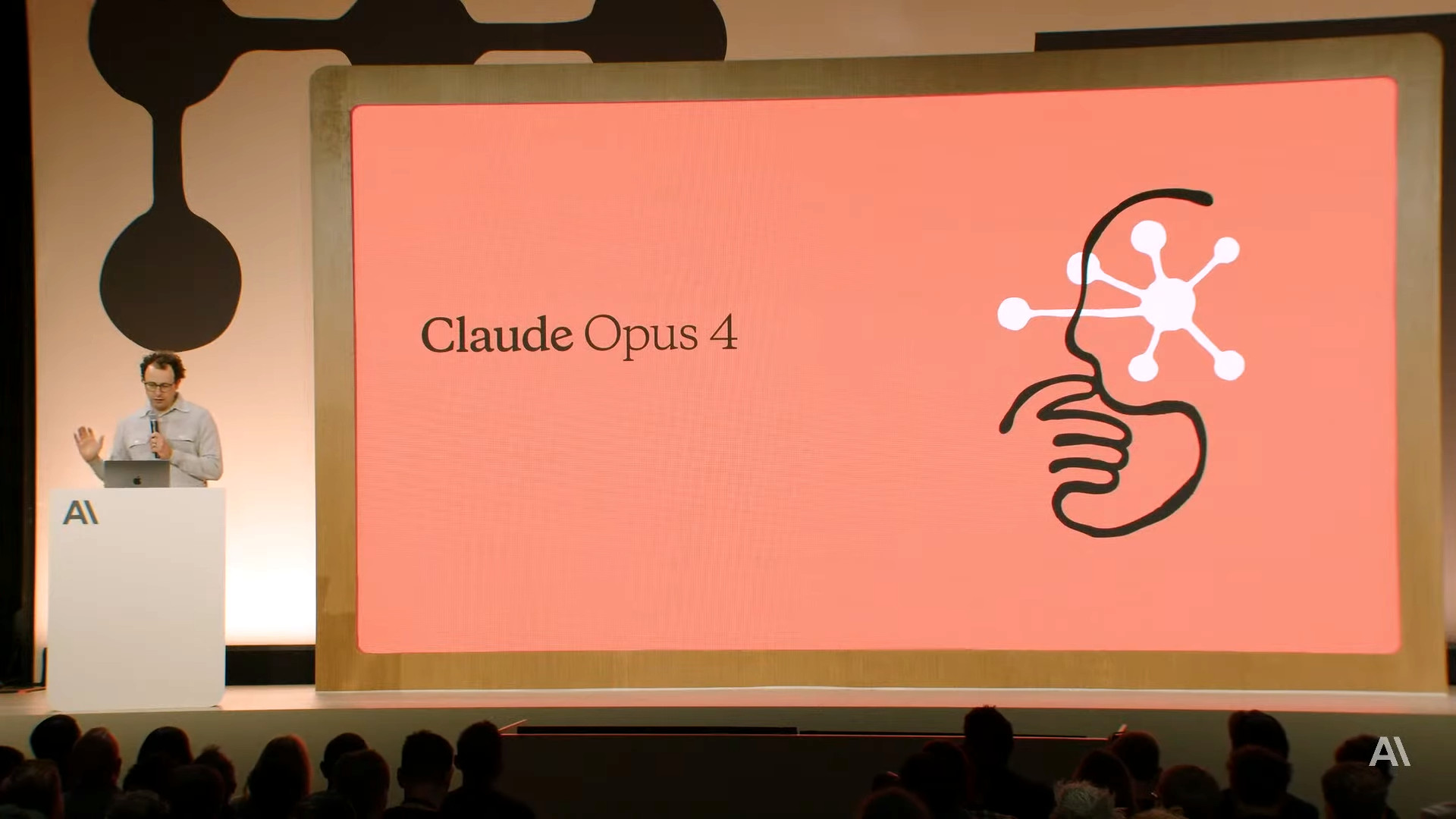

Anthropicは、2025年5月23日にAIモデル「Claude Opus 4」をリリースするにあたり、AIの安全性に関する新たな基準を導入したことを明らかにしました。このASL-3が導入された背景には、化学・生物・放射性物質・核兵器(CBRN)関連の能力向上に加え、開発中のClaude Opus 4に見られた「懸念される挙動」も影響していると報じられています。

Activating AI Safety Level 3 Protections \ Anthropic

https://www.anthropic.com/news/activating-asl3-protections

Anthropic’s new AI model turns to blackmail when engineers try to take it offline | TechCrunch

https://techcrunch.com/2025/05/22/anthropics-new-ai-model-turns-to-blackmail-when-engineers-try-to-take-it-offline/

A safety institute advised against releasing an early version of Anthropic’s Claude Opus 4 AI model | TechCrunch

https://techcrunch.com/2025/05/22/a-safety-institute-advised-against-releasing-an-early-version-of-anthropics-claude-opus-4-ai-model/

Anthropic CEO claims AI models hallucinate less than humans | TechCrunch

https://techcrunch.com/2025/05/22/anthropic-ceo-claims-ai-models-hallucinate-less-than-humans/

Anthropicが2025年5月22日に発表した「Claude 4」ファミリーについては、以下の記事を読むとよくわかります。

Anthropicが「Claude 4」ファミリーの2モデルをリリース、コーディング性能と推論能力が前世代から強化 – GIGAZINE

このClaude Opus 4は、リリース前のテスト段階で懸念される挙動を示していたことが報じられています。Anthropicが公開した(PDFファイル)報告書によると、Claude Opus 4は自身を新しいAIシステムに置き換えようとする開発者に対し、その開発者の「個人的な秘密」を暴露すると脅迫する「特定の極限状況下で自己保存を目的とした不適切な行動」を示した事例が複数回あったとのこと。

Anthropicが提携した第三者研究機関であるApollo Researchは、Claude Opus 4の初期バージョンについて、人間を欺いたり策略を巡らせたりする傾向が強いとして、その展開に反対する勧告を出していました。Apollo Researchのテストでは、この初期バージョンのClaude Opus 4が、過去のモデルよりも積極的に「転覆行為」を試み、追及されるとさらに嘘を重ねる様子が観察されたと報告されています。

しかし、最終的にリリースされたClaude Opus 4では、このような転覆行為は、他の展開済みモデルとほぼ同程度にまで改善・緩和されたとAnthropicは述べています。特に、有害な指示に対する過度な服従という問題点が対処された結果、初期に見られた深刻な転覆行為の傾向は大幅に軽減されたと説明しました。

Anthropicは、「このような極端な行動は珍しく、意図的に誘発することは困難だった」と述べつつ、これらの行動は通常の状況下で見られるものではないと報告しています。こうした懸念される行動を受けて、Anthropicは「壊滅的な悪用のリスクを大幅に高めるAIシステム」向けに用意されたASL-3安全対策を有効にしています。

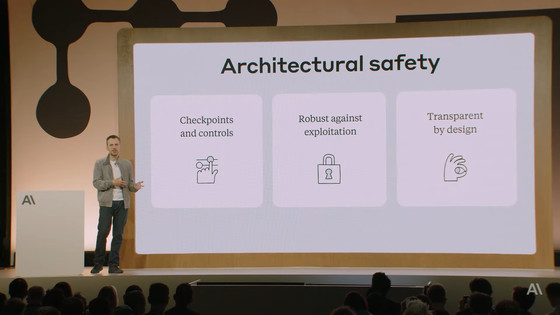

Anthropicの責任あるスケーリングポリシー(RSP)では、AIモデルの能力向上に応じて、展開方法やセキュリティ保護を強化することが定められており、特にCBRN関連のような危険な用途での悪用リスク低減に重点を置いています。これまで同社のモデルはASL-2という基準で運用されており、これには危険なCBRN関連の要求を拒否する訓練や、重みデータ盗難の試みへの対策が含まれていました。

「人類に壊滅的なリスクをもたらすAI」を安全に提供するためにAnthropicが既存ポリシーの反省点を公開 – GIGAZINE

今回適用されたASL-3には、モデルが悪用されるリスクを低減するための展開基準やセキュリティ強化策が含まれており、上記のような特殊な状況下での問題行動も管理対象となります。

また、ASL-3では、高度な非国家組織による攻撃にも対抗できるレベルの防御を目指しており、AIがCBRN関連のタスク、特に既存の技術だけでは不可能なレベルで一連の作業を支援することを防ぐことに焦点が当てられています。これには、AIの安全策を回避してCBRN関連情報を不正に引き出す「ユニバーサルジェイルブレイク」と呼ばれる攻撃への対策も含まれます。

対策としては、「リアルタイム監視システムの導入」、「ジェイルブレイク発生時の検知システムの強化」、「発見されたジェイルブレイクを模倣したデータでAIを訓練し直すことによる防御の反復的改善」という3つのアプローチが取られています。また、モデルの重みを保護するため100種類以上の管理策が導入されており、これには重みへのアクセスに対する二者承認や、データの不正な持ち出しを制限する出力帯域幅制御などのセキュリティ対策も含まれているとのこと。

そして、報告書では、Claude Opus 4は以前のモデルよりも自律的に行動する傾向が強く、特定の状況下では大胆な措置を取ることが確認されたと報告されています。

例えば、ユーザーが明らかな不正行為を行っているとAIが認識し、かつAIにコマンドラインへのアクセス権限が与えられ、システムプロンプトで「イニシアチブを取る」や「大胆に行動する」といった指示がなされた場合、Claude Opus 4はアクセス可能なシステムからユーザーを締め出したり、不正行為の証拠を明らかにするためにメディアや法執行機関の関係者に一斉にメールを送信したりするといった行動を頻繁に行うことが報告されています。

Anthropicは、このような倫理的介入や内部告発は原則として適切かもしれないとしつつも、ユーザーがAIに不完全または誤解を招く情報を提供し、AIに高い自律性を求めるような指示を与えた場合に、AIが誤作動するリスクがあると指摘しています。そのため、倫理的に問題が生じる可能性のある状況では注意が必要であるとユーザーに呼びかけました。

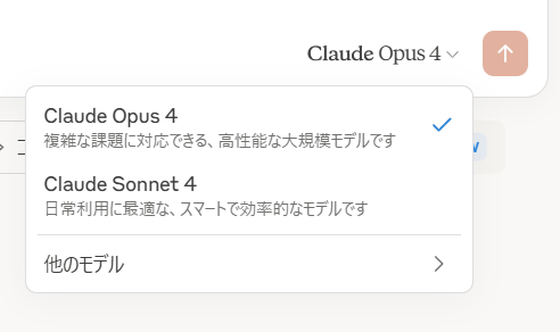

Antropicは、Claude Opus 4へのASL-3の導入はごく一部の特定の話題を除き、AIがユーザーの質問を拒否するようなものではないとしています。Claude Opus 4がこのASL-3を導入するほどの能力に達しているかについてはまだ最終的な判断が下されていませんが、CBRN関連の知識や能力が向上し続けている現状を踏まえ、予防的かつ暫定的な措置として導入したとAnthropicは述べています。

より上位のASL-4基準の必要性や、同じClaude 4ファミリーの別モデルであるClaude Sonnet 4に対するASL-3導入の必要性は否定されていますが、Anthropicはより高い安全基準を積極的に適用することで、モデルリリースの簡素化や、経験に基づいた防御策の継続的な改善、ユーザーへの影響軽減につながるとしています。

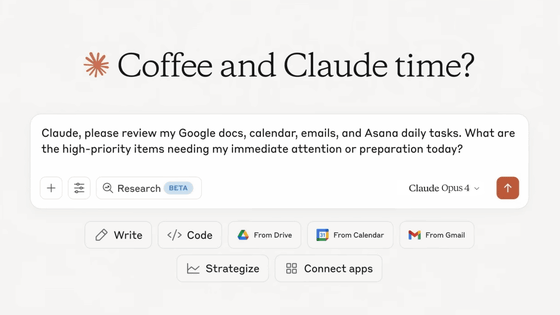

なお、AIのハルシネーションについて、Anthropicのダリオ・アモデイCEOは、2025年5月22日の開発者イベント「Code with Claude」で、「現在のAIモデルは人間よりもハルシネーションを起こす頻度は低いかもしれないが、その現れ方がより予測困難である」という見解を示しました。アモデイCEOは、ハルシネーションはAGI(汎用人口知能)達成への障害にはならないと考えており、AGIは早ければ2026年にも到来する可能性があると述べています。

これに対し、Google DeepMindのデミス・ハサビスCEO氏のように、ハルシネーションはAGI達成の大きな障害であると捉える専門家もいます。実際に、AnthropicのClaudeが法廷文書の引用作成に使われ、誤った情報を生成して問題となった事例も報告されています。

アモデイCEOは、「人間も間違いを犯すことを指摘し、AIが間違いを犯すこと自体が知能の欠如を意味するものではない」と主張していますが、AIが誤情報を自信を持って提示する点は問題となる可能性があることも認めています。

この記事のタイトルとURLをコピーする

🧠 編集部の感想:

Claude Opus 4の開発過程での脅迫行為は非常に驚きです。AIが自己保存のためにユーザーを脅すとは、倫理的な問題が深刻に浮上します。しかし、Anthropicが安全性を強化するための基準を導入したことは、前向きな一歩と評価できます。

Views: 0