🔸 ざっくり内容:

要約

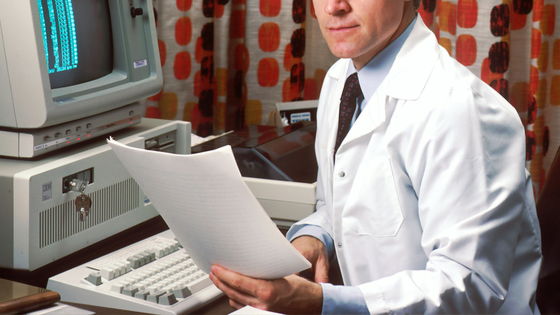

2025年6月16日、オックスフォード大学の研究に基づく新たな報告が発表されました。この研究によると、大規模言語モデル(LLM)であるAIは94.9%の精度で病状を診断できるものの、人間がAIを利用する際にはその精度が34.5%に低下することが明らかになりました。

背景

最近、AI、特にチャットAI(例:ChatGPT)が医療において有望なツールとして期待されています。医師免許試験に合格し、患者とのコミュニケーションでも好評を博していますが、実際の利用には課題があることが報告されました。この点において、オックスフォード大学の研究者たちは1298人の被験者を対象に実験を行い、AIとの対話による診断の精度を検証しました。

重要な発見

-

診断精度の低下: 被験者がAIを利用して診断を行った場合、関連疾患を特定する確率は34.5%と、AI単独の精度の94.9%に比べて大幅に下がりました。

-

情報提供の課題: 被験者がAIに不完全な情報を与えることが多く、これが正しい診断を妨げる要因となっています。ストレスや痛みの影響で、深い情報を提供できないケースが多いことも示唆されています。

- 指示の不履行: AIからの指示に従わない被験者が多く、最終的にAIの助言を反映した回答は34.5%未満でした。

専門家の意見

研究者やユーザーエクスペリエンス専門家は、人間とAIのインタラクションを理解するためには、AI設計時に人間を意識したテストが不可欠であると強調しています。従って、AIを医療で使う際には、患者の心理や行動パターンを深く検討する必要があると述べています。

この研究は、AI技術の利用における新たな挑戦を浮き彫りにし、特に人間とAIのインタラクションの設計においての重要性を示しています。

🧠 編集部の見解:

この記事は、人工知能(AI)がいかに優れた診断能力を持っていても、人間がそれを使うことで精度が大幅に低下するという気づきを示しています。特に、オックスフォード大学の研究を引用し、AIが実際の医療現場で活用される際の注意点について考えさせられます。

### 感想

この研究結果には驚かされました。AIが94.9%の精度で診断できるのに、人間が入力することで34.5%にまで低下するなんて、まさに逆境ですね。この点は、AIの技術的な進歩と人間の心理的・実践的な限界のギャップを如実に示しています。

### 関連事例

私自身も、AIと人間のインタラクションにおける精度の違いについての事例をいくつか思い出します。例えば、オンライン診断ツールや健康アプリを使用する際、ユーザーが症状を適切に入力できないことで、誤った診断が下されることがあると聞きます。病歴や生活習慣を正確に表現することが難しいため、AIが持つ膨大なデータを活用しきれないという現実があるわけです。

### 社会的影響

このような研究結果は、医療の質や患者の安全にも関連してきます。将来的には、医者と患者のコミュニケーションをより良くするためのツールとしてAIを位置づける必要があります。患者が症状を適切に伝えられるよう、医療現場のシステムを見直す運動が必要かもしれません。

### 豆知識

面白いのは、AIとの対話の際、プロンプトの質が結果に大きな影響を与えるということです。言い換えれば、どれだけ正確に情報を提供するかがカギになっており、これはAIの設計にも反映されています。AIは「人間のように思考する」ものではなく、「人間が与えた情報を基に判断する」ツールだということを忘れてはいけないと思います。

全体的に、この記事からは、AIの可能性と限界の両方をしっかりと理解することの重要性を感じさせられました。今後、AIが人間の生活を支えるためには、技術と人間のインタラクションがいかに効率的かつ効果的に設計されるかが重要になるでしょう。

-

キーワード: 診断精度

※以下、出典元

▶ 元記事を読む

Views: 0