パナソニックR&Dカンパニー オブ アメリカ(以下、PRDCA)およびパナソニック ホールディングス株式会社(以下、パナソニックHD)は17日、カリフォルニア大学 バークレー校(以下、UC Berkeley)の研究者らと共同で、言語と参照画像を用いて認識対象を指示できる対話型セグメンテーション技術「SegLLM」を開発したと発表した。

セグメンテーションとは、画像内を画素レベルで複数の領域に分割する技術で、画像認識との連携によって、例えば特定の物体を検出し、その位置や形状を正確に捉えられる。これにより、屋内での物体認識、自動車の周辺環境認識やロボットによる物体操作など、さまざまな応用が可能となる。

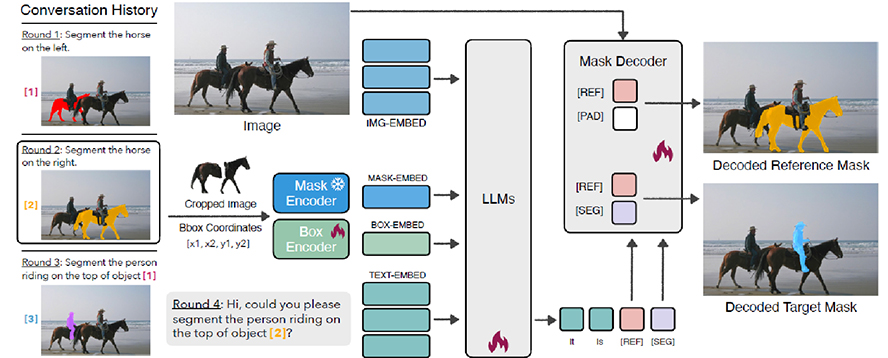

近年、画像認識の研究では大規模言語モデル(LLM)を導入して、認識対象をテキストで指示する手法が増えているが、対話的に指示を行う際、過去の対話で認識した対象をもとに新しい指示を出そうとするとテキストが複雑になり、誤認識が起こりやすいという問題があると説明。今回開発したSegLLMは、プロンプトにテキストと参照画像の入力を実現したことで、未学習の物体があっても指示文で物体の階層関係や物体間のインタラクションが認識可能になる。また、見た目が類似した物体が多数存在するような、より複雑なシーンで特定の物体のみを認識することに優れた技術となる。

同技術は、先進性が国際的に認められ、AI・機械学習技術のトップカンファレンスであるInternational Conference on Learning Representations(ICLR 2025)に採択され、4月24日~28日にシンガポールで開催される本会議で発表する。

パナソニックHDとPRDCAでは、セグメンテーション技術に関するVision and Language Model(VLM)の研究に取り組んでいる。昨今、言語モデルの進化によって認識対象をテキスト形式で柔軟に指定できる手法は増えているが、対話的にセグメンテーションを行うと、過去の対話で認識した対象を基に新しい指示を出す際に、テキストが複雑になり、誤認識が起こりやすい課題があるという。

これに対し、SegLLMは、テキストと参照画像を一緒にプロンプト入力する手法となり、具体的には参照画像をテキストと同じ特徴空間に埋め込み、LLMに入力できる形で学習を行った。同手法では、過去の対話でLLMが出力したセグメンテーション画像(マスク)を用いて、マスクされた物体のみを切り抜いた参照画像をプロンプトにして、次の指示を出すことが可能なため、テキスト入力の長さを増やさず過去の対話内容を踏まえた指示が可能となる。

論文では、SegLLMの構成に加え、対話型セグメンテーションの学習・評価データセットも提案している。提案した学習・評価データセットを用いた評価実験では、既存手法では対話が進むにつれ、認識精度の劣化が大きくなるのに対して、SegLLMは精度劣化を大幅に抑えることに成功した。

今回開発したSegLLMは、対話型セグメンテーションの性能を大幅に向上させる技術になると説明。同技術は、パナソニックHDがFastLabelと開発を進めている自動アノテーションツールに実装を予定しており、例えば未学習の物体や特定の人物が持っている物体など、従来のテキストのみの指示では検出が難しかった対象まで適用範囲が広がることで、AI開発の効率やスピードを左右するアノテーションのコスト削減と高精度化に向けて、より汎用的なツールに進化させていくとしている。

また、このようなSegLLMの特性を生かし、CPS(サイバーフィジカルシステム)に応用することで、多種多様な器具・工具が存在するような工場・生産ラインにおいても、現場ごとの学習コストを削減できるため、工場などの最適化の加速に貢献していくとしている。

Views: 0