子どもがソーシャルメディアで何をしているのかが心配だろうか。もしそうなら、Metaがティーン向けの安全策を強化し続けていることは安心材料になるかもしれない。Metaは米国時間4月8日、「Instagram」で導入している「ティーンアカウント」機能を「Facebook」と「Messenger」にも拡大すると発表した。

提供:Meta

※クリックすると拡大画像が見られます

まず米国、英国、オーストラリア、カナダで導入し、後に他の地域にも展開する。

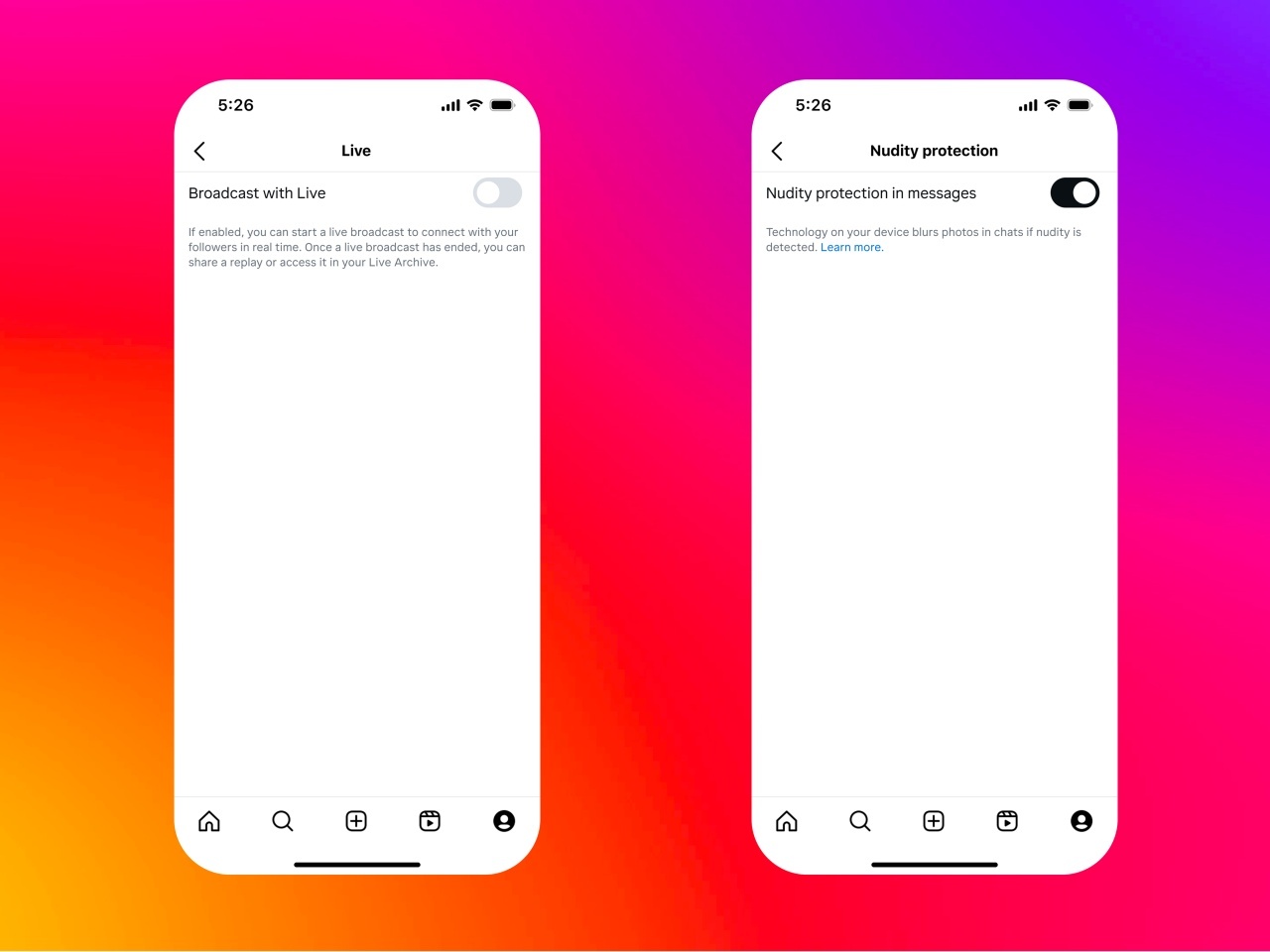

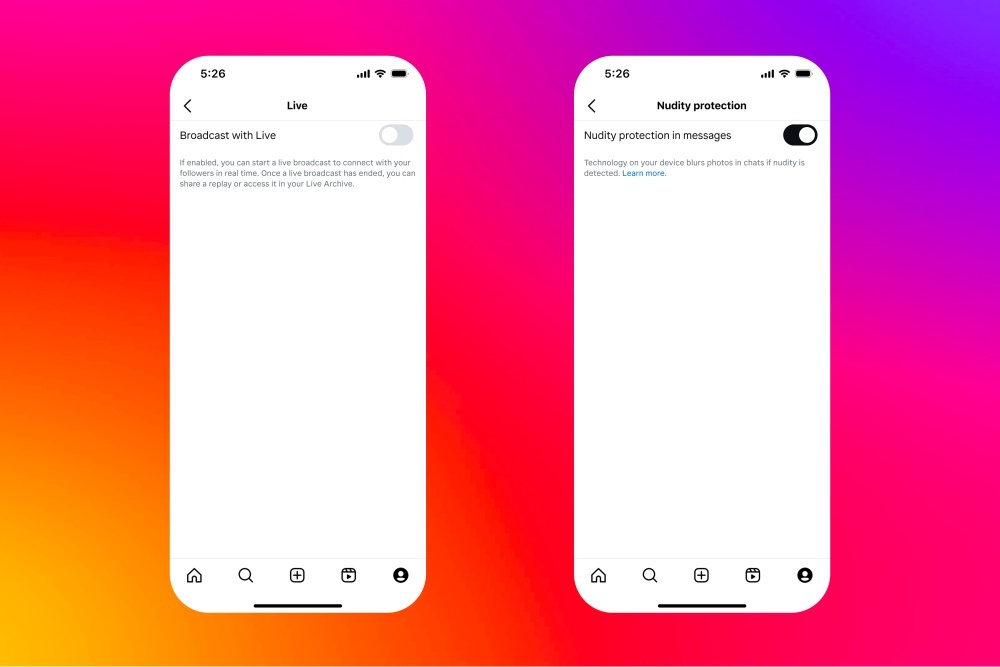

Instagramのティーンアカウントには追加の保護機能を導入する。16歳未満の子どもが保護者の許可なしにライブ配信したり、ダイレクトメッセージ(DM)のヌードとみられる画像へのぼかしをオフにしたりできないようにする機能だ。

MetaがInstagramのティーンアカウントを初めて導入したのは2024年9月で、子どもが安心して使えるプラットフォームにすることと、親が監督・管理できる選択肢を増やすことが目的だった。同社は8日の発表の中で、これまでに5400万件のアカウントをティーンアカウントに切り替えており、今後も対応を進めるとした。ティーンアカウントはデフォルトで非公開となり、問題のあるコメントやDMリクエストを自動でフィルタリングするよう、最も厳しい「非表示ワード」設定の適用などの保護機能を備えている。

保護者の同意があれば、これらの機能の一部はオフにできるが、Metaによると13~15歳のティーンの97%がデフォルトの安全策をそのまま使っているという。また、IpsosがMetaの依頼で実施した調査では、保護者の94%がティーンアカウントを有用と感じ、85%がInstagramの体験をポジティブなものにするのに役立つと答えたとしている。ただし調査対象の人数や地域は不明だ。

子どもの安全:責任は誰にあるのか

子どもの安全を訴える活動家たちは、長年にわたってソーシャルメディア企業に対し、子どもが使う環境をより安全にするよう求めてきた。進捗は遅いものの、Metaがティーンには大人とは違う保護が必要だと認め、別種のアカウントを設けた取り組みは大きな進展となった。他のプラットフォームもこれに追随し、TikTokは3月に新たなペアレンタルコントロールを導入している。

一方で、Metaはティーンアカウントを導入しながらも、自社プラットフォームにおける他の安全策を後退させていると批判を受けている。今週には米国で従来のファクトチェックプログラムを終了した。

「ここ数カ月、Metaが子どもを守る義務を後退させているように見えるのは非常に憂慮すべきことだ」と、英国の児童虐待防止協会(NSPCC)の児童オンライン安全策部門アソシエイトヘッドであるMatthew Sowemimo氏は電子メールで述べた。「FacebookやMessengerにもこの安全機能を拡大する動きは歓迎すべきだが、子どもがプラットフォームの非公開部分でも公開部分でも安心して利用できるよう、さらに取り組みを進める必要がある」

Sowemimo氏は、ティーンアカウントの導入による変化を最大限に活かすには、Meta全体で有害コンテンツを減らすための積極的な対策と組み合わせる必要があるとも述べた。「安全のための設定はオンラインの被害を防ぐうえで重要な役割を果たすが、アカウントの設定を変更できるために、結果的に子どもや保護者がオンラインでの安全を守る責任を負うことになりかねない」としている。

この記事は海外Ziff Davis発の記事を朝日インタラクティブが日本向けに編集したものです。

Views: 0