🧠 概要:

概要

この記事では、AI技術の進化に伴い、フェイクニュースや詐欺が増加する可能性が指摘されています。特に、高度なAIツールが誰でも利用できるようになり、偽情報の生成が容易になることで、社会に多くのリスクがもたらされるという警告が発されています。著者は、AIの危険性に気づき、適切な対策を取ることが重要であると訴えています。

要約

- AI技術の進歩により、フェイクニュースや詐欺が増加する懸念。

- AI生成物を見抜けない人が多く、特に高年齢層はリスクに対する認識が薄い。

- 画像や音声のクローン作成が容易になり、悪用の可能性が高まる。

- 一般人もプライバシーリスクにさらされており、SNSに投稿する際の注意が必要。

- AIに対するリテラシーの重要性を強調し、情報源の確認やAI生成物への疑念を持つことが推奨される。

- 現代の混沌とした情報環境において、AIの進化にキャッチアップしながら注意を払う姿勢が求められる。

こんにちは、AI FREAKです。

今回のはもはや自分の親に向けて書いているのですが。笑

「AIに興味がある、ない」に関わらずチェックして頂きたく、そろそろ本格的にAIがヤバいことになっています。

具体的には例えばこちらをご覧ください。

このおばあちゃんは0からAIで作っているのですが、これがAIだと見抜ける人はどのくらいいるでしょうか?

AIをずっと触っている人でさえ、パッと見では見抜けないと思います。

ましてや

「AIはまだ触ったことない」

「AIなんてChatGPTくらいしか触ったことない」

という人であれば、ほとんど気づけないでしょう。

若い世代の方達は気付けるかもしれませんが、例えばあなたの親御さんや、お爺さんお婆さん世代はどうでしょうか?

もはや

「これがAIってどういうこと…?」「何がどうAIなの…?」

と前提からわからないという可能性が高いと思います。

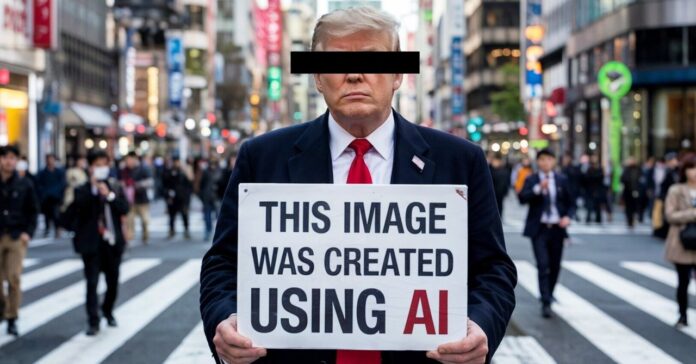

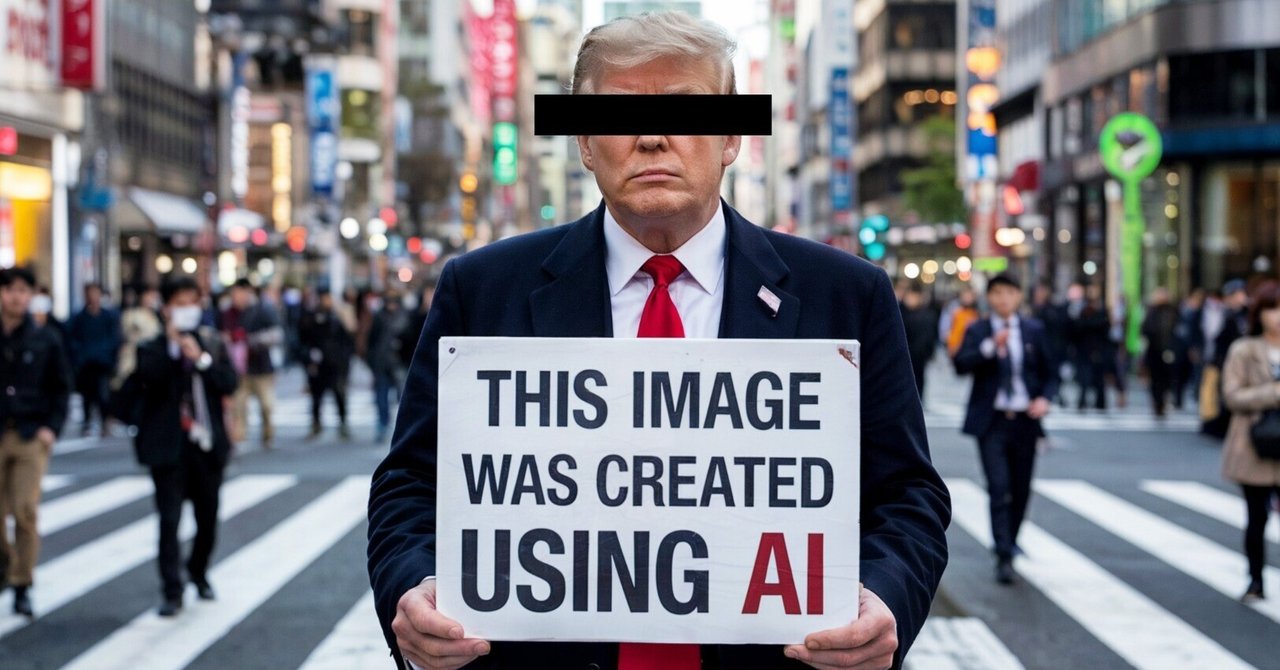

もう少し身近な例を挙げると例えば「トランプ大統領が渋谷にいる様子を作って」とお願いすると

こんな画像が簡単に作れてしまいます。

上記はちょっとAIっぽいですが、もう少し気合を入れて作ればこんな感じにも作れます。

トランプさんが渋谷にいる様子にしてみました。

これはAIで作られた画像です、という意味合いのカードも持たせていますが、かな〜りリアルですよね。

また画像以外にも例えば、声のクローンを作ることも簡単にできてしまいます。なので例えば

トランプさんの画像を作って、声を当てはめて、口元を自然に動かす

なんて事も簡単にできます。

声はつけてないですが、喋らせてみました。

要はフェイク演説みたいなものもなんでも作れてしまうわけです。

よくみると違和感はあるのですが、テレビばっかり見ているような人達からすれば、疑う余地なく信じてしまうレベルだと思います。

このような状況が、今後益々加速していくので

これから起きうるAI悪用リスク

を例にあげ、どんな被害が想定されるか、そして私たちはどう気をつければいいのかをお伝えして行きます。

ぜひ、AIに詳しい方もそうでない方も、最後まで読んでいただき、身の回りの人に少しでもこの危機感をシェアしていただければ幸いです。

AIはすでに「何でも作れる」段階に来ている

先ほどはおばあちゃんを例に挙げましたが、勿論どんな人物でも生成できます。

AIと言われなければ、ほぼほぼ気付けないですよね。

芸能人系も作れます。

これは以前に「ガクトをAI化しよう」みたいな企画があった時に作ってみたものです。

「GACKTさんをAIで作ろう」という企画が始まってたので、試しに作ってみました。

GACKT( @GACKT )さんはそもそも未来感が似合うので、ロボスーツのようなものを着せてみました。

添付の作り方は案外複雑で

=================

1️⃣ Grok等でGACKTさんのベース画像を作る

2️⃣ 作った複数の画像をLoRA化… pic.twitter.com/BaXy6xITF7— AI FREAK@AI最新情報をお届け (@AiFreak_tool) February 10, 2025

AI化というテーマだったのでロボ風ですが、もっと普通の服装をさせたらかなり自然に寄せることももちろんできます。

上記は許可があったので作ったわけですが、もちろん「その他の芸能人も作って!」と言われれば、どうとでも作れてしまいます。

悪意を持った人がこれらを活用すれば、フェイクニュースや詐欺行為を簡単に仕掛けられる時代が本格化してきているわけです。

世も末ですね本当に。

画像から住所が特定できるって知ってますか?

あとこれは相当やばいんですが、ChatGPTに画像を投げて「これってどこですか?」と聞くと、住所が特定されてしまいます。

こんな感じ。

ChatGPT o3、凄いっていうかもはや恐ろしいな

『HOOTERS GINZA』の看板が目立つからモザイクしたのに、余裕で突破されてしまった笑 pic.twitter.com/4vj29oBKqD— AI FREAK@AI最新情報をお届け (@AiFreak_tool) April 17, 2025

AI発信者のみんなで集まった時に撮った写真ですが「これどこ?」と投げたら完璧に場所を当てられました。笑

投稿にも書いている通り、『HOOTERS GINZA』の看板が目立つからモザイクしたんですが、他の要素から場所を推測されて、ドンピシャな回答がきました。

これは普通にやばいですよね。

例えば芸能人がアップした写真なんかも、簡単に場所を特定できてしまいます。場所が割れたらストーカー被害なども増えてしまうかもしれません。

勿論そんな悪用をしない人ばかりの世界を望みますが、現実はそうではないと部分もあると思います。

「こんなに簡単に住所特定できちゃうのか…」というのをしっかりと念頭に置いておけば、事前に予防できると思うので、頭の片隅にでも入れておいていただけると良いかと思います。

一般人もプライバシーリスクにさらされる時代

「芸能人や有名人はターゲットになりそうだけど、一般人は大丈夫でしょ?」と思うかもしれません。

ただ、世の中には物騒な犯罪もあるので誰でもターゲットになり得ると思います。

例えば

Instagramに載せた写真から住所を推定

自撮から顔を抽出、ディープフェイクで別のコンテンツへ流用

学校や子どもの写真を使った詐欺(子どもの顔と似たAI合成映像で誘拐を装うなど)

などなど。

想像するとキリがないですが、もう「自分は有名じゃないから平気」とは言い切れない時代ですよね。

「そんなこといったら何もSNSにアップできないじゃないか」

となってしまうのもわかりますが、ひとまずそういったリスクがあるという事を知っている事が重要だと思います。

例えば自宅付近の写真は載せない、などそれだけでも大分変わるかと。

ボイスクローン技術もヤバい

ボイスクローンとは、同じ声を作るという意味です。

わかりやすい例で言うと、ホリエモンボイスとか、ひろゆきボイスとかが世の中にはありますよね。

このチャンネルもAIで作られたものです。

ちょっと違和感がある部分もありますが、イメージとしてはこんな感じ。

もっと自然に作ることも可能ですし、知識さえあれば誰のバージョンでも作れてしまうんですよね。

つまり有名人に限らないということです。すると、オレオレ詐欺も”本当にオレの声”で行うことも技術的には可能なんですよね。

実際に海外では企業の重役に扮して、でかい契約を行って多額の額を振り込ませるような事件があったそうです。ネットフリックスで地面師が相当ブームになりましたが、あの手のなりすましもよりクオリティを上げられる世界線ということですね。

家族と電話をする際に、声は全く同じでも別人という可能性すらあるわけです。

電話では何か暗号等を決めておく必要があるかもしれませんね。

フェイクニュースの増加:どんな手口が想定される?

さらに怖いのが、大規模にフェイクニュースを量産して世論を操作する可能性ですね。

というか、既にX(Twitter)ではフェイク動画みたいなものが大量に作れられています。

コメント欄をみてみると、AIで生成されたものと気づかずにリアクションしている人が多すぎて、正直ゾッとすることも多々あります。笑

みんな頼むからAIのリテラシーをつけてくれ….

というのはかなり正直な所です。

このをここまで読んでくれる方達は、相当リテラシーが高い方達かと思います。

ただ、今は大衆は”全くといっていいほどAIに関する知識がない”ので、ご自身の周りからでもジワジワと興味づけしていくことをおすすめします。

どう対策すればいいの?

怪しい画像やニュースを見たら、まずは一次ソースを確認する習慣をつけることが重要だと思います。

あとは、そもそも「これはAIかもな?」という目線があるかどうかでも、見え方が変わってくると思います。

これから先、AIを使う人が増えるほど、善意でも悪意でもフェイクを生み出すリスクが高まります。

「ジョークだから」とネタで作ったフェイク写真が独り歩きし、混乱を生む可能性もあります。

これからの時代の心構え

「AIによるフェイクが当たり前になる時代」なんて、一昔前ならSFの話でした。

が、今は本当に目の前まで来ています。

既存の常識が通用しない、ある種の混沌とした世界が近づいているのだと理解しておくことが大事だと思います。

大前提として

「映像や画像があっても証拠にはならない」

「人の声があっても本人とは限らない」

くらいには思っておいたほうがいいと思います。

今は大袈裟に感じるかもしれないし、実際の被害は少ない方かと思いますが、報道されていないだけで色々な被害が既にある可能性もあります。

何かニュースを見た時は「もしかするとAI生成かも?」という疑いの目を持つ。

これは悲観的に見えるかもしれませんが、危機感を持つことでトラブル回避につながるなら、ある程度は仕方ないのかなと思います。

AI情報は絶対に追っておいた方いいです

フェイクや詐欺が増えるからといってAIに関心をなくすのではなく、自分自身もAIを使いこなして知識をアップデートしつつ、周囲にも少しずつ危機感を伝える。

そんな姿勢が、このAI時代にはとても必要なことかと思います。

このを読んだだけでも

「こんな感じでリアルな人物が作れるんだ」

「住所特定や、声のクローンも作れるんだ」

というのがなんとなく伝わったかと思います。

そして他の技術も今後たくさん出てくると思うので、ある程度は情報を追っかけたほうが良いです。

今回のを「まだAIを触ったことないんだよね…」という友人や家族にシェアしていただく割と驚かれるかと思います。

少しでも被害を減らすために、一緒に注意喚起を広めていきましょう。

ではまた別のでお会いしましょう!

//platform.twitter.com/widgets.js

続きをみる

Views: 0