スマホで進化するマルチモーダルLLM:GoogleのGemma-3n

概要

近年、スマートフォンで動作する大規模言語モデル(LLM)が増えてきましたが、今回は特にマルチモーダルに対応したモデル、GoogleのGemma-3nについてご紹介します。このモデルは画像認識機能も持ち合わせており、スマートフォンでどこまで利用可能かを試してみました。

Gemma-3nとは?

Gemma-3nは、2025年に登場したマルチモーダルLLMで、画像認識に対応しています。これにより、テキスト、画像、音声、動画の処理が可能になっています。Gemma-3nには2つのバリエーション、E2BとE4Bが存在し、それぞれが異なるパラメータ数を持ちます。特に、必要メモリ容量が従来の半分以下で動作する点が特徴です。これはパラメータスキップやPLEキャッシュといった技術を使用しているためです。

主な特徴

- 今回のモデルはGemma-3n-E2B(5B相当)とGemma-3n-E4B(8B相当)の2種類。

- テキストだけでなく、画像や音声情報も同時に処理可能。

- スマホでも軽快に動作し、プライバシー面でも安心。

実際にスマホで動かしてみる

Gemma-3nを試すための環境として、Google AI StudioとGoogle AI Edgeが利用できます。しかし、前者はテキスト処理専用です。一方、後者ではマルチモーダル機能を楽しむことができます。

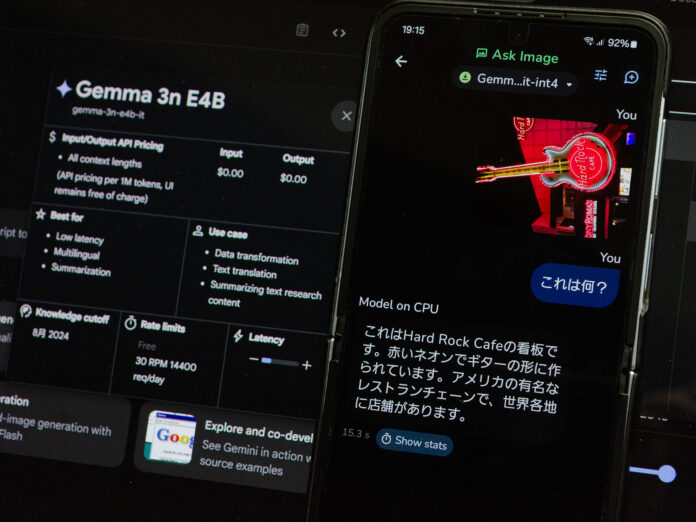

アプリは基本的にサイドロード形式で提供されており、Huggingfaceのアカウントも必要です。起動時にモデルがダウンロードされ、新しい操作が可能になります。例えば、「Ask Image」という機能では画像をアップロードし、その内容を認識させることができます。

実際の使用例

フィーチャーとして、渋谷のスクランブル交差点の写真を試してみました。画像をアップロードし、「ここは何処ですか?」と尋ねると、正確な回答が返ってきました。

回答は次の通りです:

「これは日本の渋谷スクランブル交差点です…。活気あふれる商業地区であることがわかります。」

また、別の画像からはラーメン屋の名前も正しく認識されましたが、認識ミスもありました。例えば、桜丘カフェに関しての問い合わせでは存在しないURLが返されてしまったため、注意が必要です。

動作の安定性と今後の展望

Gemma-3nの処理速度は実用レベルですが、特定の状況下ではハルシネーション(誤認識)が見られました。これは特にローカル情報に関して問題となります。今後、Web検索との統合が求められるでしょう。

また、現在の技術進化により、スマートフォンでのLLMがさらに豊かになっています。今後の発展が期待される分野です。

まとめ

GoogleのGemma-3nは、スマホローカルで動作するマルチモーダルLLMとして、画像認識も可能な優れた技術です。日本語での高精度な応答ができ、プライバシー保護にも配慮されています。進化を続けるこの分野に目が離せません。

この情報は2025年6月17日に公開されたもので、最新の技術の進展に基づいています。今後さらに興味深い進展があることを期待しましょう。

🧠 編集部より:

この記事は、スマートフォンで動作するマルチモーダル対応の言語モデル、Gemma-3nについて紹介しています。このモデルはテキストだけでなく、画像も認識できるという特徴を持っています。以下に、Gemma-3nの特長や使用方法、試用レポートなどの補足を行います。

Gemma-3nの特長

- マルチモーダル処理: Gemma-3nはテキスト、画像、音声、動画のデータを扱うことができ、特に強力なのは画像認識機能です。

- 省メモリでの高速処理: 従来のモデルよりも少ないメモリで動作し、スマートフォンでも高いパフォーマンスを実現しています。例えば、Gemma-3n-E2Bモデルは、実質的には5Bに相当する性能を持ちながら、2B弱のメモリで動作します。

使用方法

- Google AI StudioとGoogle AI Edge: これらのプラットフォームでGemma-3nを試すことが可能ですが、Google AI Studioでは画像処理が含まれていないため、主にテキストでのやり取りが中心になります。対して、AI Edgeではマルチモーダル機能が体験できます。

- Androidに特化した利用法: 一部のAPKをサイドロードすることで、Androidデバイス上でGemma-3nを利用可能です。詳細な手順は、こちらのGitHubページを参照してください。

実際の利用例とフィードバック

- 画像認識の成功例: 渋谷スクランブル交差点の画像を解析し、その特徴や景観について適切な応答を生成しました。これは、日本国内で特に有名な場所であったため、モデルが正確に情報を把握できた結果です。

- 認識エラーの事例: 一方で、特定のカフェに関連するサイトのURLを提示したものの、そのサイトは実在しませんでした。

背景と豆知識

- 言語モデルの進化: 過去数年で、GPUを搭載したPCでさえ難しいとされていた日本語処理が、現在ではスマートフォン上で自然に行えるようになっています。特に2025年からはマルチモーダル機能の実装が進んでおり、さらに利便性が向上しています。

今後の展望

- 機能の拡張: 音声認識や動画認識の機能を含むモデルが今後リリースされる予定です。また、外部の情報源と連携することができれば、より高精度な情報提供が期待されます。

Gemma-3nの詳細については、こちらのGoogle AIの公式ドキュメントをご覧ください。この記事を通じて、スマートフォン上でのマルチモーダルLLMの可能性を感じ取っていただければ幸いです。

-

キーワード: マルチモーダルLLM

この技術は、テキスト、画像、音声、動画を同時に処理できる能力を持つ大規模言語モデル(LLM)を指し、特にスマートフォンでの実行が可能である点が注目されています。具体的には、GoogleのGemma-3nモデルがこの進化を代表しています。

※以下、出典元

▶ 元記事を読む

Views: 2