自分のグラボでAIを動かせるかを簡単に計算するウェブアプリの紹介

公開日: 2025年07月28日 07時00分

カテゴリ: ウェブアプリ

最近、AI技術が進化する中で、AIモデルを実行するためには十分なVRAM(ビデオRAM)容量を持ったグラフィックボードが必要です。そこで活躍するのが、無料で使えるウェブアプリ「LLM Inference: VRAM & Performance Calculator」です。このアプリは、自分のPC環境で特定のAIモデルが動作可能かをサクッと確認できる便利なツールです。

アプリの機能と使い方

このアプリでは、さまざまなデバイスのVRAM容量やAIモデルのVRAM使用量をデータベースとして提供しています。ユーザーはAIモデルと使用デバイスを選択するだけで、そのモデルを実行するためのVRAMが足りているかどうかを調べることができます。

- 選択肢: アプリ画面左上から実行したいAIモデルを選択し、中央からデバイスを選ぶだけ。

- 結果表示: 選択したAIモデルのVRAM消費量とデバイスのVRAM使用率が表示されます。

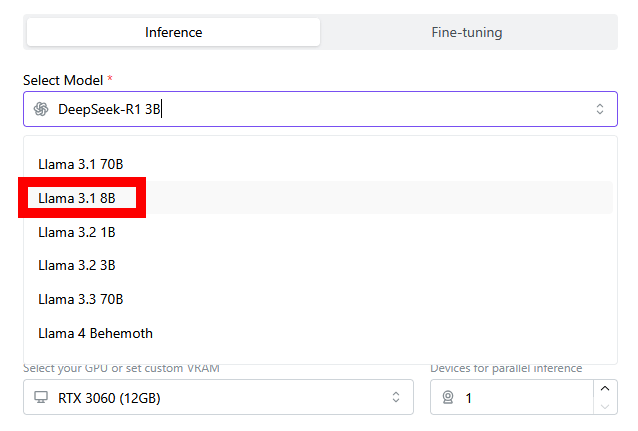

例えば、初期設定では「DeepSeek-R1 3B」AIモデルが選ばれており、「RTX 3060 (12GB)」デバイスを使用した場合、VRAM使用率は66.8%で問題なく実行できることがわかります。

具体的な使用例

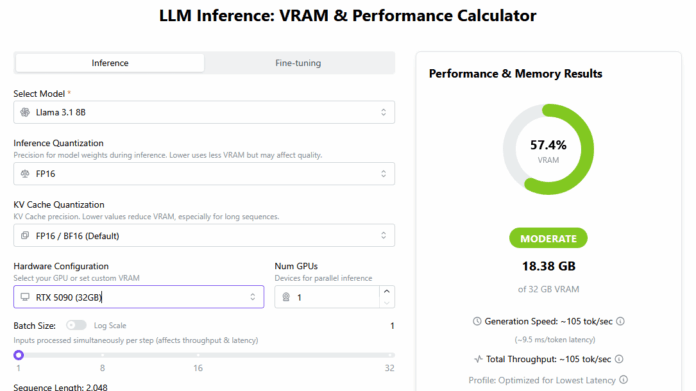

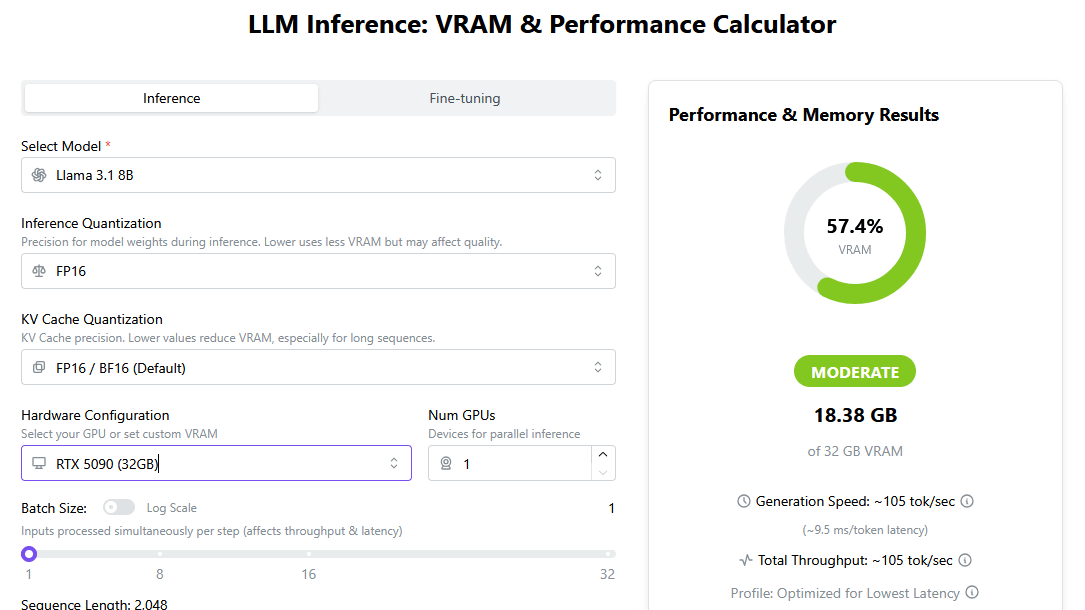

アプリはシンプルで、選択肢を変更することで様々なシミュレーションが可能です。例えば、「Llama 3.1 8B」モデルを選ぶと、実行には18.38GB以上のVRAMが必要ですが、RTX 3060の12GBでは対応できないことが確認できました。

一方、「RTX 5090 (32GB)」デバイスに変更すると、「Llama 3.1 8B」を問題なく動かせることがわかります。

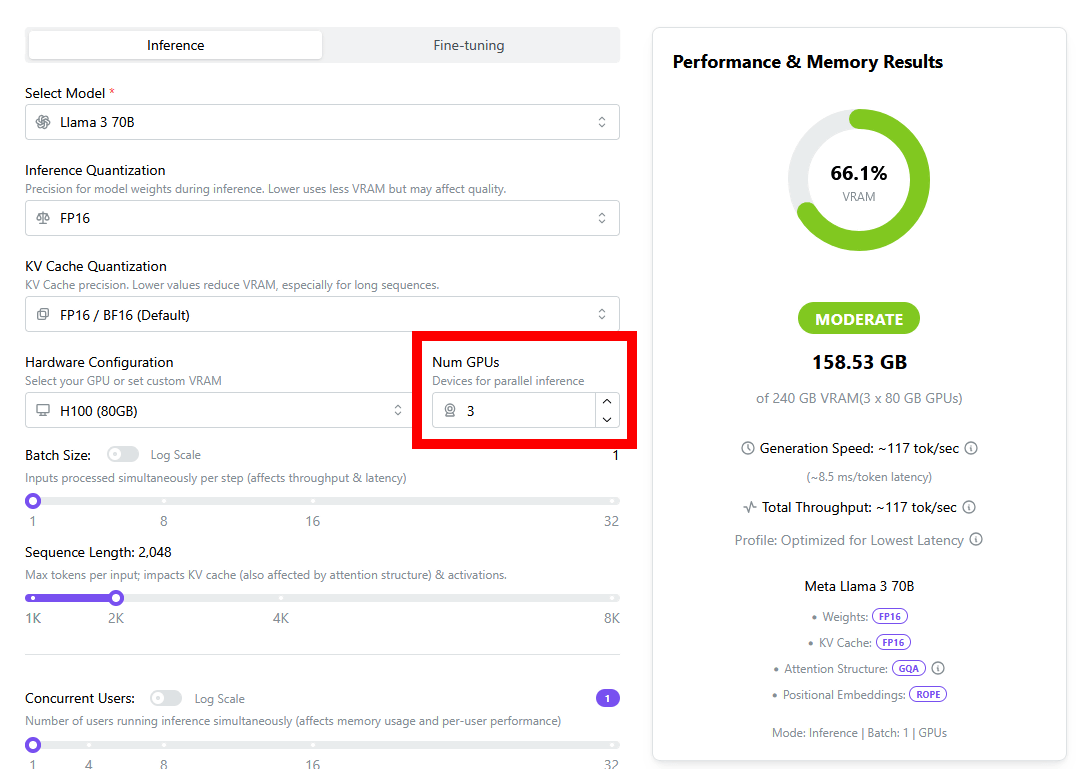

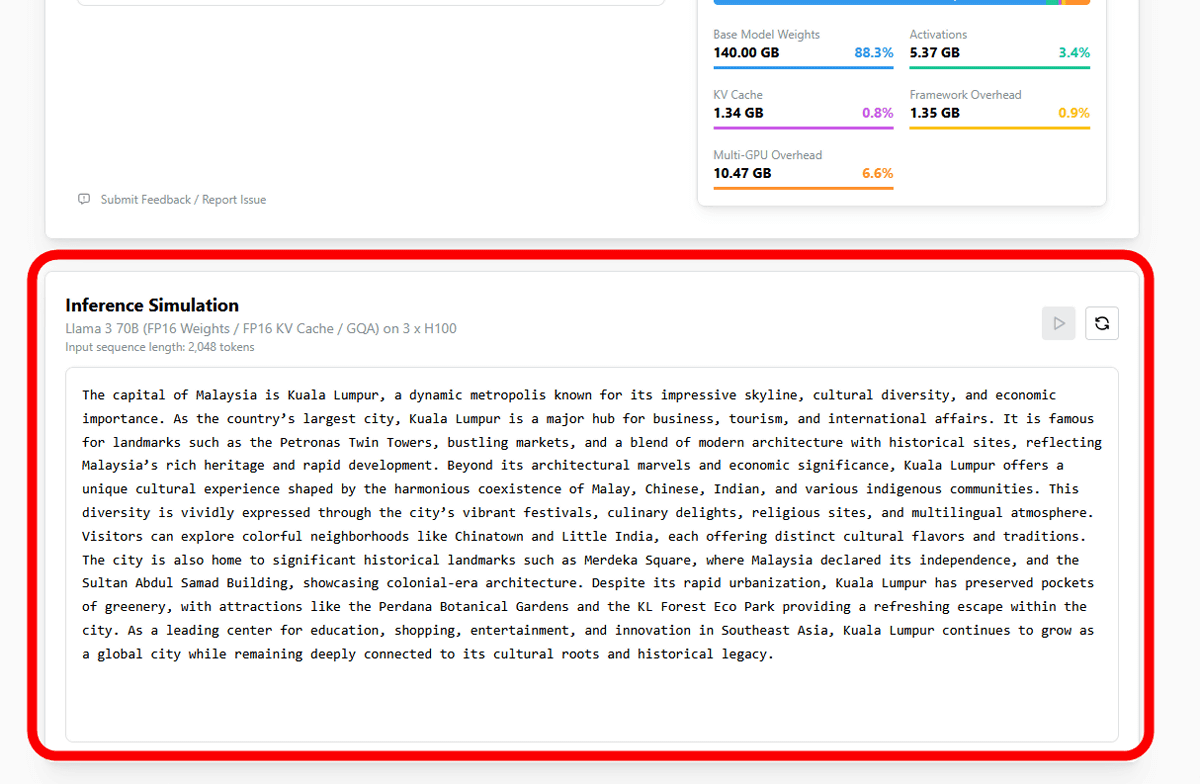

また、高性能なデバイス「H100 (80GB)」を使用し、さらに複数台のデバイス選択が可能です。例えば、「LLaMA 3 70B」モデルを実行する際、1台のH100では不可能でしたが、3台で並列処理すれば実行可能です。

トークン処理速度のデモ

加えて、アプリでは選択したAIモデルとデバイスの組み合わせによるテキスト出力速度のデモも体験できます。これにより、実際の性能を疑似的に感じられるポイントも見逃せません。

まとめ

このウェブアプリ「LLM Inference: VRAM & Performance Calculator」を利用すれば、自分のグラフィックボードでAIを動かせるかどうかを簡単に確認することができます。今後のAIモデルの利用に向けた準備として、ぜひ活用してみてはいかがでしょうか。

アプリはこちら: LLM Inference: VRAM & Performance Calculator

🧠 編集部より:

AIとグラボの関係

最近のAIモデル、特に大規模言語モデル(LLM)は、その実行にかなりのVRAM(ビデオRAM)を必要とします。VRAMは、GPUがデータを一時的に保存するためのメモリで、高速にデータを読み書きできるため、特に画像処理やGPU処理が多いタスクに適しています。AI処理では、このVRAM容量が足りないと、モデルを実行できなくなります。

VRAM容量と性能を計算するウェブアプリ

「LLM Inference: VRAM & Performance Calculator」は、ユーザーが自分のグラフィックボードやAIモデルのVRAM使用量をカンタンに比較できるアプリです。これにより、自分のPC環境が特定のAIモデルを実行可能かを瞬時に判断できます。例えば、NVIDIAの「RTX 3060」と「RTX 5090」のVRAM容量を比較して実行可能なモデルを知ることができます。

アプリケーション使い方

- 機種選択: 画面上部から希望のAIモデルを選びます。

- デバイス選択: 中央部分で、自分の持っているGPUを選択します。

- 結果の確認: VRAMの使用率が表示され、指定したモデルが実行可能かが分かります。

豆知識

- GPUの進化: モデルやGPUは年々進化しており、かつては数GBのVRAMがあれば十分だったが、現在の大規模モデルでは数十GBが必要になることもあります。

- データセンター向けハードウェア: H100などのデータセンター向けGPUは非常に高性能ですが、個人のPCにはなかなか手が届かない場合が多いです。

リンク集

- VRAM計算ツール: LLM Inference: VRAM & Performance Calculator

- AIモデルに関する詳細情報: AIモデルとGPUの関係

このウェブアプリを利用して、AIモデルを自分の環境で実行できるかどうか気軽に確認してみてください。興味深いAI技術を楽しんでくださいね!

-

キーワード: VRAM計算機

※以下、出典元 ▶ 元記事を読む

Views: 0